Projekt CADistency: KI als Brücke zwischen technischer Zeichnung und CAD-Modell

KI-gestützte Zusammenführung von 2D- und 3D-Informationen

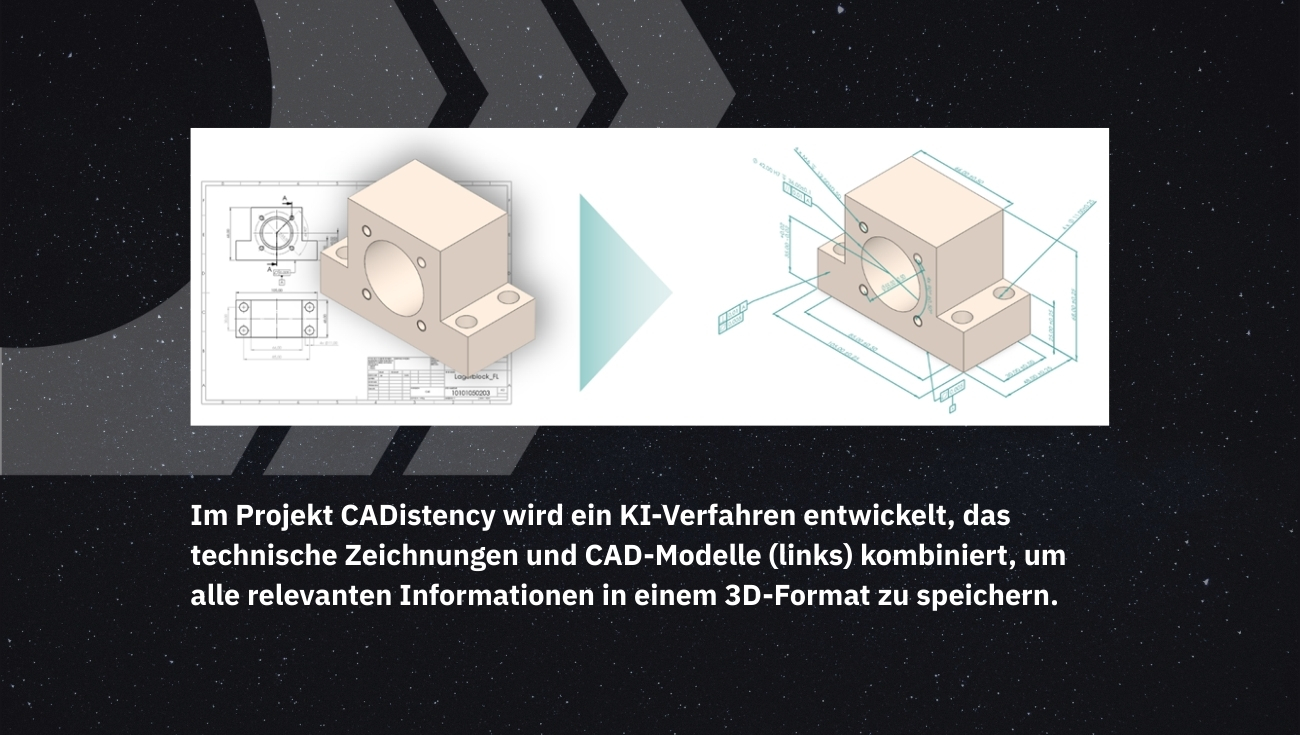

In der Fertigung werden neben CAD-Dateien technische Zeichnungen verwendet, aus denen etwa Maßhaftigkeiten manuell ausgelesen werden. Im Forschungsprojekt CADistency sollen daher durch eine KI-gestützte Zusammenführung der 2D- und 3D-Informationen Kostenvorteile durch durchgängige Automatisierungslösungen erzielt werden.

Hintergrund und Zielsetzung des Projekts CADistency

Mit dem Fortschreiten der Digitalisierung in der industriellen Fertigung gewinnt die konsistente, verlustfreie Bereitstellung technischer Produktinformationen zunehmend an Bedeutung. In der Praxis liegen diese Informationen häufig in zwei parallelen Formaten vor: als klassische 2D-Zeichnungen sowie als 3D-CAD-Modelle. Um redundante Datenpflege, manuelle Übertragungsprozesse und daraus resultierende Fehlerquellen zu vermeiden, verfolgt das Forschungsprojekt CADistency das Ziel, wesentliche Zeichnungsinhalte – insbesondere Maße, Toleranzen und Oberflächenspezifikationen – strukturiert und vollständig im 3D-Modell abzubilden.

Das Projekt wird gemeinsam vom Institut für Datenoptimierte Fertigung (IDF) der Hochschule Kempten, das in zahlreichen Kooperationen zur KI-gestützten Optimierung von CAx-Prozessen forscht, und dem auf KI-gestütztes Konstruktionsdatenverständnis und Beschaffungslösungen spezialisierten Unternehmen PartSpace durchgeführt.

Model Based Definition

Im Rahmen der sog. Model Based Definition (MBD) werden technische Produktinformationen nicht länger separat in 2D-Zeichnungen gepflegt, sondern direkt im 3D-CAD-Modell strukturiert hinterlegt. Dazu zählen insbesondere Maße, Toleranzen, Oberflächenspezifikationen und weitere produktionsrelevante Angaben, die als Product Manufacturing Information (PMI) digital eingebettet werden. Ziel ist es, eine zentrale, maschinenlesbare Datenquelle bereitzustellen, die den durchgängigen Informationsfluss entlang der gesamten Prozesskette unterstützt.

In der Fertigungsvorbereitung können auf Basis dieser Informationen automatisch Bearbeitungsstrategien, NC-Programme oder Arbeitspläne generiert werden. Die manuelle Auswertung technischer Zeichnungen entfällt ebenso wie fehleranfällige Übertragungsprozesse. Auch für übergeordnete Aufgaben wie Kapazitätsplanung, Aufwandsschätzung oder Verfahrensempfehlung wird durch die konsolidierte Datenstruktur ein einheitlicher Informationsstand geschaffen, der automatisierte und KI-gestützte Auswertungen ermöglicht.

Darüber hinaus bietet MBD im Kontext des Product Lifecycle Management (PLM) wesentliche Vorteile: Änderungen an Produktdaten lassen sich zentral verwalten und systematisch in alle nachgelagerten Anwendungen überführen – von der Konstruktion über die Fertigung bis zur Qualitätssicherung. Die Reproduzierbarkeit technischer Entscheidungen wird gestärkt, und die Zusammenarbeit zwischen Abteilungen sowie mit externen Partnern verbessert sich durch die konsistente Datenbasis erheblich.

Technische Grundlage für diesen Ansatz ist das standardisierte Austauschformat STEP AP 242, das die Kombination von Geometrie- und PMI-Daten in einer einzigen Datei erlaubt. Aufgrund seiner herstellerübergreifenden Struktur eignet sich STEP AP 242 besonders für den verlustfreien Datenaustausch zwischen unterschiedlichen CAD-, CAM- und PLM-Systemen. Es bildet damit das bevorzugte Zielformat für die Umsetzung von MBD im Projekt CADistency.

CNNs für technische Zeichnungen

Im Projekt CADistency kommen verschiedene Methoden des maschinellen Lernens zum Einsatz, um Informationen aus technischen Zeichnungen und 3D-CAD-Modellen automatisiert auszuwerten. Eine zentrale Rolle spielen dabei Convolutional Neural Networks (CNNs), die sich besonders für die Analyse visueller Daten eignen.

Künstliche neuronale Netze orientieren sich konzeptionell an der Funktionsweise biologischer Nervenzellen und sind in der Lage, aus Trainingsdaten relevante Merkmale und Zusammenhänge zu lernen. CNNs sind eine speziell für Bildverarbeitung entwickelte Architektur: Sie betrachten Eingabedaten als zweidimensionales Pixelraster und analysieren diese mithilfe lernfähiger Filter, die über das Bild gleiten. Jeder Filter erkennt spezifische visuelle Merkmale – etwa Kanten, Linien oder geometrische Grundformen – und erlaubt damit eine strukturierte Auswertung auch komplexer Zeichnungsinhalte.

PartSpace nutzt CNNs im Rahmen seines KI-Produkts PartSpace AI, um technische Zeichnungen automatisiert auszulesen. Dabei werden typische Elemente wie Maßangaben, Toleranzen oder Symbole zuverlässig erkannt und strukturiert digital aufbereitet. Diese Vorarbeit stellt einen wichtigen Baustein im Projekt CADistency dar: Die digitalisierten Inhalte der Zeichnungen lassen sich nun gezielt mit den Geometrieelementen des 3D-CAD-Modells verknüpfen. Daraus entsteht eine sogenannte multimodale Datenbasis, in der Informationen aus 2D- und 3D-Quellen zusammengeführt werden. Dies ermöglicht eine präzise und kontextbezogene Übertragung der relevanten Zeichnungsinhalte in das 3D-Modell – ein zentraler Schritt auf dem Weg zur standardisierten Modellbeschreibung im Format STEP AP 242.

GNNs für CAD-Modelle

Graph Neural Networks (GNNs) sind darauf ausgelegt, strukturierte Daten in Form von Graphen zu verarbeiten. In einem Graphen repräsentieren Knoten einzelne semantische Einheiten – im CAD-Kontext beispielsweise Bauteilflächen – und Kanten modellieren deren topologische Beziehungen wie z.B. das Angrenzen benachbarter Flächen. GNNs lernen durch den wiederholten Informationsaustausch zwischen den Knoten, wie sich geometrische Elemente zueinander verhalten, und können daraus Rückschlüsse auf funktionale oder fertigungsrelevante Zusammenhänge ziehen.

Im Projekt CADistency werden GNNs eingesetzt, um die zuvor mittels CNNs aus der technischen Zeichnung extrahierten Inhalte mit der Geometriestruktur des 3D-CAD-Modells zu verknüpfen. Das CAD-Modell wird hierzu als Graph interpretiert, dessen Knoten die Flächen des Bauteils darstellen. Die aus der Zeichnung extrahierten Bildelemente – etwa Maßangaben oder Toleranzsymbole – werden als numerische Information in den Graphen eingebracht und dienen als Grundlage für eine anschließende Knotenklassifikation: Das Netzwerk lernt, welche Flächen mit welchen PMIs zu verknüpfen sind.

PartSpace setzt graphbasierte Verfahren bereits zur automatisierten Ableitung technologischer Merkmale – wie Bohrungen, Senkungen oder Biegungen – und deren Überführung in Arbeitsplanvorschläge ein. Parallel dazu wurde am IDF eine graphbasierte KI zur Vorhersage von CNC-Fertigungszeiten entwickelt, die im Vergleich zu regelbasierten Methoden eine um 58% verbesserte Vorhersagegenauigkeit erzielt. Hierzu wurden strukturiert vorliegende Bauteilinformationen mit der CAD-Information kombiniert. Auch im Projekt CADistency wird dieser multimodale Ansatz verfolgt, bei dem 2D-Zeichnungsinformationen und 3D-CAD-Strukturen gemeinsam ausgewertet werden. Auf dieser Basis kann das Modell relevante Flächen automatisch identifizieren und mit den richtigen PMI-Typen anreichern – ein wesentlicher Schritt zur durchgängigen Digitalisierung der Produktbeschreibung im STEP AP 242-Format.

KI zum 2D/3D-Matching

Zur Integration der aus der 2D-Zeichnung extrahierten Inhalte in das 3D-CAD-Modell wurden die von den CNNs extrahierten Bildmerkmale in die graphbasierte Repräsentation des CAD-Modells eingebracht. Dabei wurden die Bauteilflächen als Knoten modelliert und ihre topologischen Nachbarschaften über gemeinsame Kanten abgebildet. Ein nachgeschaltetes Graph Neural Network wurde auf diese strukturierte Eingabe trainiert, um per Knotenklassifikation zu bestimmen, welche Flächen mit welchen PMI-Typen (z.B. Rundheit, Ebenheit) zu assoziieren sind.

Die Kombination beider Netzwerke erlaubt eine semantisch präzise Verknüpfung der in 2D dargestellten Fertigungsinformationen mit den entsprechenden Geometrieelementen im 3D-Modell. Auf einem unabhängigen Validierungsdatensatz konnte so eine Klassifikationsgenauigkeit von über 97% erreicht werden. Dieser Befund zeigt die technische Umsetzbarkeit des Ansatzes auf einfachen, synthetisch generierten Bauteilen und bildet die Grundlage für die weitere Generalisierung auf komplexere Geometrien und reale Konstruktionsdaten im weiteren Projektverlauf.

Ausblick und Fazit

Für den weiteren Projektverlauf bestehen zentrale Herausforderungen vor allem in der steigenden geometrischen und semantischen Komplexität realer Bauteile. Besonders anspruchsvoll ist dabei der Umgang mit situationsabhängigen Konventionen, historischen Darstellungen und impliziten Zeichnungsintentionen, die ein hohes Maß an domänenspezifischem Wissen erfordern. Hinzu kommt die Heterogenität des Datenmaterials in der industriellen Praxis: Neben standardisierten CAD-Exporten finden sich auch gescannte oder handschriftlich ergänzte Zeichnungen – teils mit stark variierender Qualität. Solche Eingangsdaten erfordern robuste, fehlertolerante Ansätze sowohl in der Vorverarbeitung als auch in der Interpretation.

Trotz dieser Herausforderungen verdeutlichen die bisherigen Ergebnisse die technische Machbarkeit und das Potenzial des gewählten Ansatzes. Gelingt die Skalierung auf realitätsnahe und variantenreiche Bauteile, kann dies einen erheblichen Beitrag zur Effizienzsteigerung in der Fertigungsvorbereitung leisten – durch reduzierte manuelle Aufwände, geringere Fehlerquoten und kürzere Durchlaufzeiten. Langfristig eröffnet dies neue Möglichkeiten für datengetriebene Planungs- und Automatisierungsprozesse entlang der gesamten digitalen Prozesskette.

Um CAD und Zeichnungen zu verbinden, KI nutzen

Um CAD und Zeichnungen zu verbinden, KI nutzen

Verwandte Artikel

Konstruktionsdaten als Taktgeber: Wie KI Kosten und Komplexität im technischen Einkauf senkt

Automatisierte Zeichnungsanalyse mit KI reduziert Kosten, Komplexität und Entscheidungsrisiken im technischen Einkauf.

Welchen ROI können Hersteller von einer modernen Transformation des Einkaufs erwarten?